Wirtschaftskriminelle schlagen immer häufiger zu und richten immer größere Schäden an. Sie werden – auch dank Künstlicher Intelligenz (KI) – immer professioneller. ChatGPT und Co. haben die Welt verändert: Was einerseits große Effizienzsteigerungen, Arbeitserleichterungen und ganz neue Chancen eröffnet, spielt andererseits auch Betrügern in die Hände – denn ihnen wird die Arbeit nun erleichtert mit vielen neuen Möglichkeiten. Das bereitet vielen Unternehmen große Sorgen.

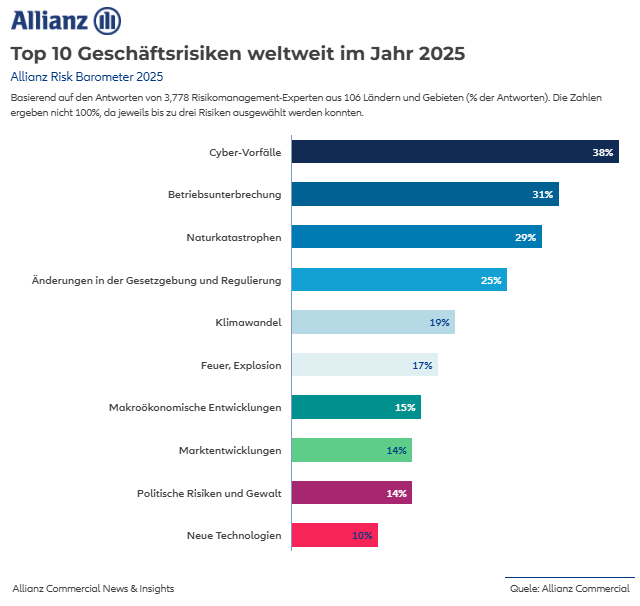

Dies spiegelt auch das aktuelle Allianz Risk Barometer von Allianz Commercial wider. Insbesondere die Sorge vor Cyberkriminalität treibt Unternehmen um: Fast die Hälfte der deutschen Unternehmen sieht darin das aktuell größte Risiko.

Dies deckt sich mit der Allianz Trade Schadensstatistik. Social-Engineering-Betrugsmaschen, bei denen Menschen durch Kriminelle manipuliert werden, verursachen schon seit vielen Jahren hohe finanzielle Schäden bei Unternehmen. Wirtschaftskriminelle professionalisieren ihre Betrugsmaschen mit KI-Tools noch weiter und Deepfakes stellen beim „Social-Engineering-Betrug“ große Gefahr dar.

Dabei sind längst nicht nur Finanzabteilungen von Unternehmen betroffen, sondern auch Banken und Finanzdienstleister geraten zunehmend ins Visier der Kriminellen. Sie zählen zu den vier beliebtesten Branchen der „Menschen-Hacker“.

Vor Kurzem startete am Frankfurter Landgericht ein Prozess gegen eine Betrügerbande wegen dem Vorwurf des 25-fachen Betrugs. Dabei handelt es sich um klassische „Fake President“ Fälle. Mitarbeitende von mehreren Banken in Bremerhaven, Bayern und Gießen fielen auf die Masche herein: Sie hatten nach dem Anruf eines angeblichen lokalen Unternehmensgeschäftsführers – der tatsächlich Kunde der jeweiligen Bank war – hohe Geldsummen überwiesen. Einige Überweisungen konnten zwar noch storniert und Gelder teilweise zurückgeholt werden. Insgesamt aber entstand ein Schaden von knapp 740.000 Euro– das Geld mussten die Banken ihren Kunden erstatten.

Die beliebtesten Betrugsmaschen

Zu den „Social Engineering“-Betrugsmaschen zählen Zahlungsbetrug (Umleitung von Zahlungsströmen durch z.B. manipulierte Rechnungen), Bestellerbetrug (Umleitung von Warenströmen durch geänderte Lieferadressen) und Fake President, bei der sich die Täter als vermeintliche Chefs ausgeben und Mitarbeitende anweisen, Geldsummen für vermeintliche Geschäftstransaktionen auf betrügerische Konten zu überweisen.

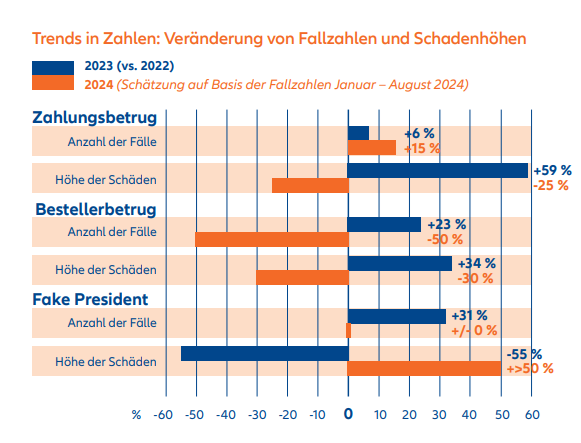

Gerade der Zahlungsbetrug erfreute sich in den letzten Jahren laut Allianz Trade Schadensstatistik großer Beliebtheit bei Kriminellen: Allein 2023 sind die Schäden mit einem Plus von über 50 % drastisch gestiegen, vor allem getrieben durch Großschäden. Dabei traf es längst nicht nur Großunternehmen, sondern auch viele kleine und mittelständische Unternehmen quer durch alle Branchen. Die gefälschten Rechnungen sind in vielen Fällen praktisch nicht von den Originalen zu unterscheiden. 2024 gab es zwar nicht mehr ganz so viele Großschäden, aber eine Entwarnung gibt es dennoch nicht, denn die Anzahl der Fälle steigt weiterhin an. Die Schäden sind in den meisten Fällen immer noch groß genug, um gerade bei kleinen und mittelständischen Unternehmen große Löcher in die Kasse zu reißen.

Auch Fake President erlebt seit 2022 ein überraschendes Revival – trotz großer Bekanntheit der Betrugsmasche. Dieser Trend setzte sich auch 2023 fort – allerdings nur bei den Fallzahlen, die nochmals knapp ein Drittel (+31 %) in die Höhe schnellten. Die verursachten Schäden pro Fall sanken in den letzten Jahren zunächst deutlich. In den meisten Fällen lagen die Schadenssummen bei niedrigen bis mittleren sechsstelligen Summen.

Zuletzt aber nahmen auch die Großschäden wieder zu. 2024 gab es weiterhin eine relativ große, wenn auch gleichbleibende Anzahl an Fällen – aber das Schadenvolumen bei den Unternehmen ist deutlich in die Höhe geschnellt. Das deutet darauf hin, dass die Betrüger sich mit KI-Tools weiter professionalisieren.

Künstliche Intelligenz als Beschleuniger des Betrugs

KI hilft den Betrügern, vorhandene Lücken zu finden. Sie können KI-Tools für ihre Zwecke trainieren, zum Beispiel indem sie die KI Rechnungen fälschen lassen oder mit ein paar E-Mails des CEO füttern. Es sind nur einige Prompts notwendig und schon spuckt diese einen Text aus, der genau nach dem Chef klingt: Anrede, Tonalität und Schreibstil passen, und die E-Mail wirkt absolut glaubwürdig. Und genau diese vermeintliche Echtheit setzt die üblichen Prozesse und Regeln außer Kraft.

Und dann wäre da noch Voice Cloning. Vor ein paar Jahren war das noch etwas für absolute Spezialisten und die Qualität oft fraglich. Heute gibt es die digitale Kopie einer menschlichen Stimme quasi auf Knopfdruck und „von der Stange“ mit Hilfe von KI-Tools, die entweder frei verfügbar sind oder die man für ganz kleines Geld erwerben kann – und die täuschend echt an die Realität herankommen. Das eröffnet auch Betrügern ganz neue Horizonte – die Hürden sind so niedrig wie noch nie, sie brauchen immer weniger Skills für wirklich gut gemachte Angriffe.

Das könnte sukzessive zu einem Anstieg der Schäden durch gefälschte Dokumente oder Deepfakes führen. Doch wie können Mitarbeitende Deepfakes überhaupt erkennen? Das ist gar nicht so leicht, aber es gibt einige Anzeichen. Sie sollten beispielsweise auf eine eher unnatürliche Betonung achten, die Sprachmelodie, aber auch darauf, wie authentisch Bewegungen oder Blinzeln wirken. Auch schlechte Audio- oder Videoqualität, unerklärliche Nebengeräusche oder Veränderungen von Licht und Hautton könnten wichtige Hinweise sein. Ebenso eine schlechte Lippensynchronisation zum Gesagten. Sie können ihr Gegenüber auch einfach bitten, sich mit dem Finger zur Nase zu fassen, damit haben künstliche Intelligenzen bisher Schwierigkeiten.

Allerdings ist die Entwicklung hier rasant, so dass es bald Deepfakes geben wird, bei denen das schon alles nicht mehr gilt. Deshalb ist es sinnvoll, sich unternehmensintern Gedanken über Kontrollmechanismen zu machen. Denn die Kriminellen arbeiten nonstop an den verbleibenden Defiziten und beherzigen solche „Erkennungs-Tipps“ als erstes. Das ist ihr Input für die nächste Evolutionsstufe. Das wird definitiv ein Katz-und Maus-Spiel werden.

Schutz durch Awareness, Richtlinien und Unternehmenskultur

Umso wichtiger ist die Sensibilisierung der Mitarbeitenden durch regelmäßige Trainings und Schulungen. Oder regelmäßige simulierte Betrugs-Mails aus der eigenen IT-Sicherheit als Test. Auch die Verpflichtung des CEOs, keine Überweisungen in Videocalls anzuweisen oder eine Losung für gewisse Transaktionen kann eine geeignete Schutzvorkehrung sein. Wichtig ist nur, dass sich am Ende alle daran halten.

Und der allerwichtigste Punkt ist Offenheit: Eine gute Fehler- und eine offene Unternehmenskultur sind die wichtigsten Hebel gegen kriminelle Machenschaften. Das hat ein kürzlich vereitelter Fake-President- Fall eindrucksvoll bewiesen, bei dem eine kluge Rückfrage des Mitarbeitenden das ganze Konstrukt einstürzen ließ wie ein Kartenhaus.

Prozesse und Sicherheitsrisiken verändern sich durch KI. Deshalb sollten Unternehmen klare Regeln und verbindliche Richtlinien definieren, was erlaubt ist und was nicht. Es ist zum Beispiel sicher keine gute Idee, interne Informationen bei ChatGPT einzugeben, um bei einer Mail an den Chef Zeit zu sparen, denn der Algorithmus nutzt auch diese Informationen, um zu lernen.

Mit grundlegenden Regeln lassen sich schon einige Sicherheitslücken schließen. Regelmäßige Stresstests, KI-Detection-Tools oder Multifaktor-Authentifizierung sind ebenfalls Optionen, Risiken zumindest zu minimieren. Für die Zukunft könnte auch Fingerprinting, also die Authentifizierung eines E-Mail-Absenders per Fingerabdruck eine Lösung sein, um eine weitere Sicherheitsstufe zu implementieren.

Aber die Kriminellen werden genau diese Punkte berücksichtigen und Lösungen finden, sie zu umgehen. Und: Die Schwachstelle Mensch bleibt – zumal externe Täter wie beim Social Engineering ja nur eine Seite der Medaille sind: Die Innentäter am Schreibtisch nebenan richten weiterhin die meisten Schäden an. Auch diese unbequeme Wahrheit bleibt. Insofern spielen neben Schutzmaßnahmen, insbesondere geeignete Absicherungslösungen wie beispielsweise eine Vertrauensschadenversicherung, eine große Rolle für Unternehmen, um sich vor erheblichen finanziellen Schäden zu schützen.

Rüdiger Kirsch ist Rechtsanwalt und Betrugsexperte bei Allianz Trade, die mit der Vertrauensschadenversicherung (VSV) Unternehmen gegen finanzielle Schäden durch kriminelle Handlungen eigener Mitarbeitender oder externer Dritter absichert. Seit mehr als 35 Jahren beschäftigt er sich mit Wirtschaftskriminalität und den neuesten Betrugsmaschen wie Social Engineering.